Googleは、機械学習アルゴリズムを加速するために開発した独自のAI向けカスタムチップ「Tensor Processing Unit(TPU)」のベンチマークを論文にて公開しました。(PDF)

同社は、2016年5月のI/O開発者会議でTPUチップを初めて発表しましたが、それ以来公表がなく、今回初めてベンチマークを公開しました。

同社独自のベンチマークに基づいた数字なため留意が必要ですが、データは以下になります。

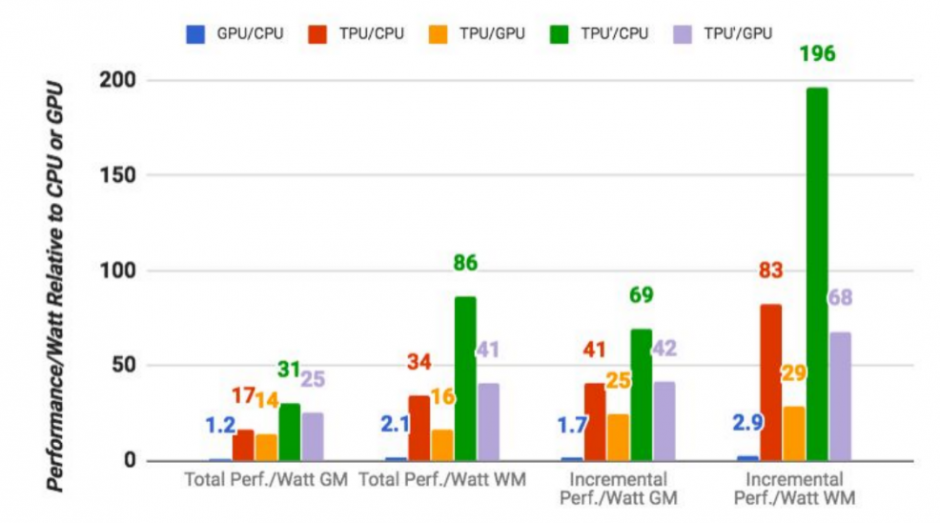

TPUは、標準のGPUとCPUの組み合わせ(ここではIntelのHaswell Xeon E5-2699 v3チップとNVIDIAのTesla K80 GPU)よりも、Googleの機械学習ワークロードを実行する際に平均15〜30倍高速と示します。TOPS/Wattは、約30〜80倍高性能。

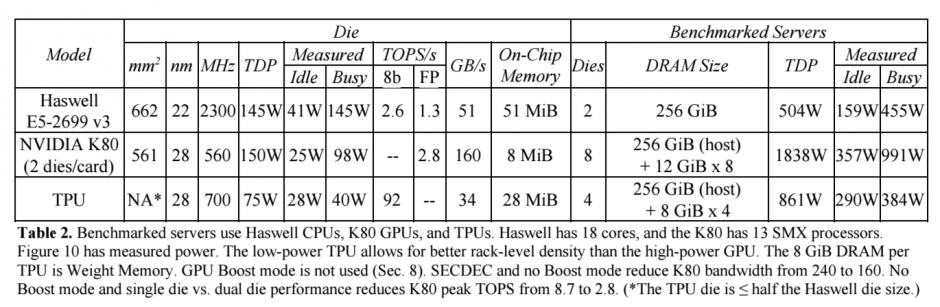

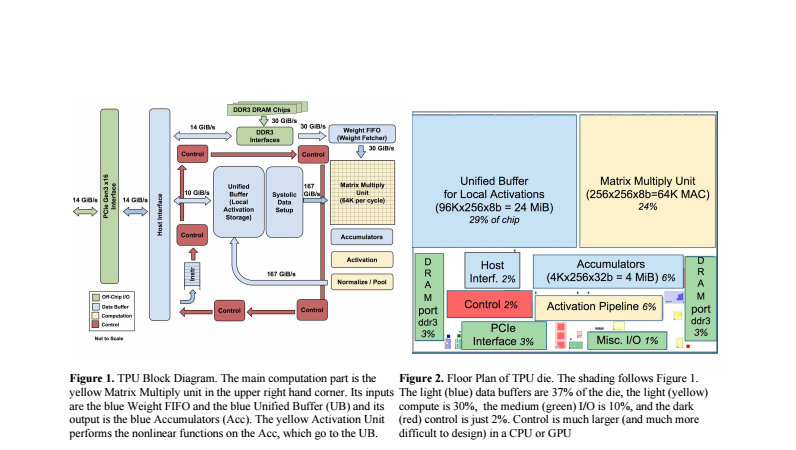

TPUとは、GoogleのTensorFlowアルゴリズムを加速するために設計された700MHzで動作する28nmのチップです。メインロジックユニットには65,536個の8ビット乗算累算ユニットと24テラバイト/秒を提供する24Mバイトのキャッシュが搭載されています。

論文はこちら。(PDF)

関連

Google、人工知能ソフトウェアライブラリ「TensorFlow(テンソルフロー)」のバージョン1.0を正式にリリース。言語翻訳でも活用 | Seamless